Small Language Models are the Future of Agentic AI

התרגלנו לחשוב שבעולם הבינה המלאכותית, הגודל קובע. מודלי שפה ענקיים (LLM), כמו אלה שעומדים בבסיס ChatGPT, מדהימים את הדמיון ביכולתם לכתוב שירים, ליצור קוד ולנהל שיחות פילוסופיות. ענקיות הטכנולוגיה משקיעות מיליארדים ביצירת "מוחות" גדולים וחזקים יותר ויותר עבור הבינה המלאכותית. אבל מה אם הדרך הזו היא מבוי סתום?

מאמר שפורסם לאחרונה על ידי חוקרים מ-NVIDIA, אחת החברות המובילות בתעשייה, קורא תיגר על התפיסה הזו. במאמרם, "מודלי שפה קטנים הם העתיד של בינה מלאכותית מבוססת סוכנים", הם טוענים: העתיד אינו שייך למודלים אוניברסליים ומפלצתיים, אלא לצוותים של "מומחים" מהירים, זולים ויעילים – מודלי שפה קטנים (SLM).

הבעיה עם הענקים: יקר ולא יעיל

כיום, רוב סוכני הבינה המלאכותית – תוכנות שלא רק עונות על שאלות אלא מבצעות עבורנו משימות (מזמינות כרטיסים, מתכננות פרויקטים, מנהלות בית חכם) – פועלים על גבי מודלי LLM עצומים. זה דומה לשימוש במחשב-על כדי לעבוד עם מחשבון.

דמיינו שאתם מבקשים מהעוזר הדיגיטלי שלכם להוסיף פגישה ליומן. מאחורי הקלעים, הבקשה הפשוטה שלכם נשלחת למרכז נתונים ענק, שם היא מעובדת על ידי מודל עם מאות מיליארדי פרמטרים, המסוגל לנתח את כתבי שייקספיר. התוצאה – זה עובד, אבל זה:

- יקר: כל בקשה כזו עולה כסף אמיתי, מה שמתבטא בחשבונות אסטרונומיים על מחשוב ענן למפתחים ובמחירי מנוי גבוהים למשתמשים.

- איטי: העברת הנתונים והעיבוד במודל הענק יוצרים עיכוב (latency).

- מוגזם: 99% מכוח העיבוד של המודל אינו מנוצל למשימה כה פשוטה.

החוקרים ב-NVIDIA טוענים שנפלנו למלכודת: אנו משתמשים ב"מוח" אוניברסלי כדי לבצע משימות ייעודיות וחוזרות על עצמן. זה לא יעיל כלכלית וגם לא בר-קיימא מבחינה סביבתית.

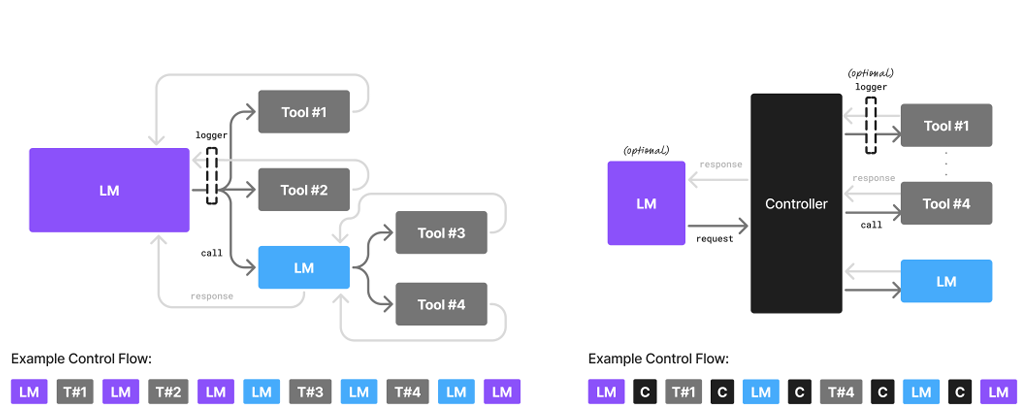

הפתרון: צוות של מומחים ייעודיים

מה הם מציעים במקום? רעיון שנמצא בשימוש נרחב בהנדסה ובעסקים – מודולריות. במקום גאון בינה מלאכותית אחד, ענק ומסורבל, הם מציעים צוות שלם של מודלי שפה קטנים (SLM), שכל אחד מהם אומן למשימה ספציפית.

SLM הוא רשת נוירונים קומפקטית מספיק כדי לפעול על מחשב נייד רגיל או אפילו על סמארטפון. הוא לא יוכל להרהר על משמעות החיים, אבל הוא יבצע את תפקידו בצורה מושלמת.

איך זה יעבוד בפועל?

בואו נדמיין את אותו סוכן בינה מלאכותית, אבל כזה הבנוי על ארכיטקטורת SLM. אתם מבקשים ממנו לתכנן טיול.

- ה"מנהל" הראשי (SLM קטן) מקבל את בקשתכם: "תכנן לי טיול לסוף שבוע בסנקט פטרבורג".

- הוא מזהה את תתי-המשימות וקורא ל"מומחים" אחרים:

- SLM לחיפוש טיסות פונה ל-API של חברות התעופה ומוצא את האפשרויות הטובות ביותר.

- SLM לחיפוש מלונות מחפש מלונות מתאימים לפי הקריטריונים שלכם.

- SLM מדריך תיירים מכין רשימה קצרה של אתרים מומלצים.

- SLM מזכיר אישי מעצב את כל המידע בצורה יפה לתוכנית אחידה.

כל אחד מהמודלים האלה קטן, פועל במהירות הבזק וצורך מינימום משאבים. ורק אם תשאלו שאלה מורכבת ופתוחה, כמו "ספר לי על המאפיינים האדריכליים של סגנון הבארוק בסנקט פטרבורג", המערכת עשויה לפנות לעזרה למודל LLM גדול ו"משכיל".

היתרונות של הגישה ה"קטנה"

מערכת כזו, לדעת NVIDIA, עולה על המודל הנוכחי בכל היבט:

- חיסכון: עלויות עיבוד הבקשות עשויות לרדת פי 10-30. זה יהפוך את סוכני הבינה המלאכותית לנגישים יותר לכולם.

- מהירות: התשובות יהיו כמעט מיידיות, מכיוון שרוב החישובים יכולים להתבצע ישירות על המכשיר שלכם.

- גמישות: הרבה יותר קל לעדכן או "לאמן מחדש" מודל קטן אחד (למשל, כדי להתאימו לממשק חדש של אתר הזמנות) מאשר לגעת ב-LLM ענק.

- אבטחה ופרטיות: אם המודלים פועלים על המכשיר שלכם, אין צורך לשלוח את הנתונים האישיים שלכם לשרתים חיצוניים.

מה מונע את המעבר?

אם הכל כל כך טוב, מדוע אנחנו עדיין לא חיים בעולם של SLM? המחברים מציינים שלושה חסמים עיקריים:

- אינרציית השקעות: חברות כבר השקיעו מיליארדי דולרים בתשתיות עבור LLM והן לא ממהרות לשנות כיוון.

- הרגל למדדי ביצועים (בנצ'מרקים): מפתחים רגילים למדוד את "העוצמה" של מודלים במבחנים כלליים של ידע, ולא ביעילותם במשימות אמיתיות.

- רעש שיווקי: כל התהילה ותשומת הלב התקשורתית מופנות למודלים הגדולים, בעוד שמודלי SLM נשארים בצל.

עם זאת, המחברים בטוחים שהכדאיות הכלכלית וההיגיון הבריא ינצחו בסופו של דבר. הם אף מציעים אלגוריתם קונקרטי שבאמצעותו מפתחים יכולים להעביר בהדרגה את הסוכנים שלהם מ-LLM ל-SLM, על ידי איסוף נתונים על בקשות נפוצות ואימון מודלים ייעודיים על בסיסם.