Small Language Models are the Future of Agentic AI

Nous nous sommes habitués à penser que dans le monde de l’intelligence artificielle, la taille compte. Les grands modèles de langage (LLM), comme ceux qui animent ChatGPT, fascinent par leur capacité à écrire des poèmes, à générer du code et à tenir des conversations philosophiques. Les géants de la technologie investissent des milliards pour créer des « cerveaux » d’IA toujours plus grands et plus puissants. Mais si cette voie était une impasse ?

Un récent article de chercheurs de NVIDIA, l’un des fleurons de l’industrie, remet en question cette idée. Dans leur publication, « Les petits modèles de langage sont l’avenir de l’IA agentique », ils affirment que l’avenir n’appartient pas à de monstrueux modèles universels, mais à des équipes de « spécialistes » rapides, économiques et efficaces : les petits modèles de langage (SLM).

Le problème avec les géants : cher et inefficace

Aujourd’hui, la plupart des agents d’IA — ces programmes qui ne se contentent pas de répondre à des questions mais accomplissent des tâches pour nous (réserver des billets, planifier des projets, gérer une maison connectée) — fonctionnent sur d’énormes LLM. C’est un peu comme utiliser un supercalculateur pour se servir d’une calculatrice.

Imaginez que vous demandiez à votre assistant IA d’ajouter une réunion à votre calendrier. En coulisses, votre simple requête est envoyée à un immense centre de données, où elle est traitée par un modèle doté de centaines de milliards de paramètres, capable d’analyser l’œuvre de Shakespeare. Le résultat ? Ça fonctionne, mais c’est :

- Cher : Chaque requête coûte de l’argent réel, ce qui se traduit par des factures astronomiques de cloud computing pour les développeurs et des abonnements coûteux pour les utilisateurs.

- Lent : Le transfert de données et le traitement sur un modèle géant créent une latence.

- Démesuré : 99 % de la puissance du modèle n’est pas utilisée pour une tâche aussi simple.

Les chercheurs de NVIDIA affirment que nous sommes tombés dans un piège : nous utilisons un « cerveau » universel pour effectuer des tâches hautement spécialisées et répétitives. C’est économiquement inefficace et écologiquement insoutenable.

La solution : une équipe de spécialistes

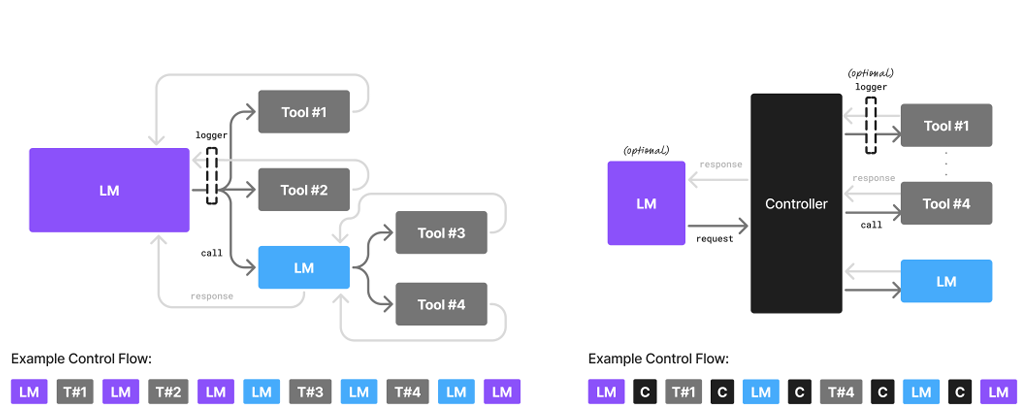

Que proposent-ils en échange ? Une idée utilisée depuis longtemps en ingénierie et en affaires : la modularité. Au lieu d’un unique génie de l’IA, gigantesque et peu maniable, ils suggèrent toute une équipe de petits modèles de langage (SLM), chacun entraîné pour sa propre tâche.

Un SLM est un réseau neuronal suffisamment compact pour fonctionner sur un ordinateur portable standard ou même un smartphone. Il ne pourra pas philosopher sur le sens de la vie, mais il remplira sa fonction à la perfection.

Comment cela fonctionnerait-il en pratique ?

Imaginons le même agent IA, mais construit sur une architecture de SLM. Vous lui demandez de planifier un voyage.

- Le « répartiteur » principal (un petit SLM) reçoit votre demande : « Planifie un week-end à Paris ».

- Il identifie les sous-tâches et fait appel à d’autres « spécialistes » :

- Un SLM chercheur de vols se connecte aux API des compagnies aériennes et trouve les meilleures options.

- Un SLM hôtelier recherche des hôtels adaptés à vos critères.

- Un SLM guide touristique compile une courte liste de sites incontournables.

- Un SLM secrétaire met en forme toutes ces informations de manière élégante dans un itinéraire unique.

Chacun de ces modèles est petit, fonctionne à la vitesse de l’éclair et consomme un minimum de ressources. Ce n’est que si vous posez une question complexe et ouverte, comme « Parle-moi des caractéristiques architecturales du baroque à Paris », que le système pourrait faire appel à un grand LLM « érudit ».

Les avantages de l’approche « petite »

Selon NVIDIA, un tel système surpasse le modèle actuel sur tous les fronts :

- Rentabilité : Les coûts de traitement des requêtes pourraient chuter de 10 à 30 fois, rendant les agents IA plus accessibles à tous.

- Vitesse : Les réponses seraient quasi instantanées, car la plupart des calculs peuvent se faire directement sur votre appareil.

- Flexibilité : Il est beaucoup plus facile de mettre à jour ou de « ré-entraîner » un petit modèle (par exemple, pour l’adapter à la nouvelle interface d’un site de réservation) que de toucher à un immense LLM.

- Sécurité et confidentialité : Si les modèles fonctionnent sur votre appareil, vos données personnelles n’ont pas besoin d’être envoyées sur des serveurs tiers.

Qu’est-ce qui freine la transition ?

Si tout est si formidable, pourquoi ne vivons-nous pas déjà dans un monde de SLM ? Les auteurs identifient trois obstacles principaux :

- L’inertie des investissements : Les entreprises ont déjà investi des milliards de dollars dans l’infrastructure pour les LLM et ne sont pas pressées de changer de cap.

- L’habitude des benchmarks : Les développeurs ont l’habitude de mesurer la « puissance » des modèles sur des tests de connaissances générales, et non sur leur efficacité dans des tâches réelles.

- Le battage médiatique : Toute la gloire et l’attention des médias vont aux grands modèles, tandis que les SLM restent dans l’ombre.

Néanmoins, les auteurs sont convaincus que la viabilité économique et le bon sens finiront par l’emporter. Ils proposent même un algorithme concret pour que les développeurs puissent progressivement faire passer leurs agents des LLM aux SLM, en collectant des données sur les requêtes courantes et en entraînant des modèles spécialisés sur celles-ci.