Small Language Models are the Future of Agentic AI

Nos hemos acostumbrado a pensar que, en el mundo de la inteligencia artificial, el tamaño importa. Los modelos de lenguaje grandes (LLM), como los que impulsan a ChatGPT, deslumbran la imaginación con su capacidad para escribir poemas, generar código y mantener conversaciones filosóficas. Los gigantes tecnológicos invierten miles de millones en crear «cerebros» de IA cada vez más grandes y potentes. Pero, ¿y si este camino es un callejón sin salida?

Un reciente trabajo de investigadores de NVIDIA, uno de los buques insignia de la industria, desafía esta idea. En su artículo, «Los modelos de lenguaje pequeños son el futuro de la IA agéntica», afirman que el futuro no pertenece a los monstruosos modelos universales, sino a equipos de «especialistas» rápidos, económicos y eficientes: los modelos de lenguaje pequeños (SLM).

El problema con los gigantes: caro e ineficiente

Hoy en día, la mayoría de los agentes de IA —programas que no solo responden preguntas, sino que realizan tareas por nosotros (reservar billetes, planificar proyectos, gestionar un hogar inteligente)— funcionan con enormes LLM. Esto es como usar un superordenador para manejar una calculadora.

Imagina que le pides a tu asistente de IA que añada una reunión a tu calendario. Entre bastidores, tu simple solicitud se envía a un centro de datos masivo, donde es procesada por un modelo con cientos de miles de millones de parámetros, capaz de analizar a Shakespeare. El resultado es que funciona, pero es:

- Caro: Cada solicitud cuesta dinero real, lo que se traduce en facturas astronómicas de computación en la nube para los desarrolladores y precios de suscripción elevados para los usuarios.

- Lento: La transferencia de datos y el procesamiento en un modelo gigante generan latencia.

- Excesivo: El 99% de la potencia del modelo no se utiliza para una tarea tan simple.

Los investigadores de NVIDIA dicen que hemos caído en una trampa: estamos utilizando un «cerebro» universal para realizar tareas altamente especializadas y repetitivas. Esto es económicamente ineficiente y ecológicamente insostenible.

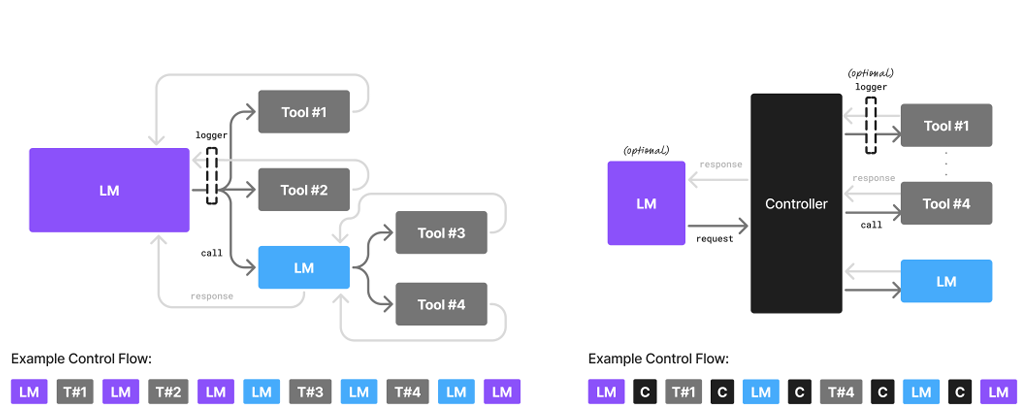

La solución: un equipo de especialistas

¿Qué proponen a cambio? Una idea que se ha utilizado durante mucho tiempo en la ingeniería y los negocios: la modularidad. En lugar de un único genio de IA, gigantesco y torpe, proponen todo un equipo de modelos de lenguaje pequeños (SLM), cada uno entrenado para su propia tarea.

Un SLM es una red neuronal lo suficientemente compacta como para funcionar en un ordenador portátil estándar o incluso en un smartphone. No podrá reflexionar sobre el sentido de la vida, pero cumplirá su función a la perfección.

¿Cómo funcionaría en la práctica?

Imaginemos el mismo agente de IA, pero construido sobre una arquitectura de SLM. Le pides que planifique un viaje.

- El «despachador» principal (un SLM pequeño) recibe tu solicitud: «Planifica un viaje de fin de semana a Madrid».

- Identifica las subtareas y llama a otros «especialistas»:

- Un SLM buscador de vuelos se conecta a las API de las aerolíneas y encuentra las mejores opciones.

- Un SLM agente de hoteles busca hoteles adecuados según tus criterios.

- Un SLM guía turístico compila una breve lista de atracciones imprescindibles.

- Un SLM secretario formatea toda la información de manera elegante en un plan unificado.

Cada uno de estos modelos es pequeño, funciona a la velocidad del rayo y consume un mínimo de recursos. Solo si haces una pregunta compleja y abierta, como «Háblame de las características arquitectónicas del barroco en Madrid», el sistema podría recurrir a la ayuda de un LLM grande y «erudito».

Ventajas del enfoque «pequeño»

Según NVIDIA, un sistema así supera al modelo actual en todos los frentes:

- Rentabilidad: Los costes de procesamiento de las solicitudes podrían reducirse entre 10 y 30 veces, haciendo que los agentes de IA sean más accesibles para todos.

- Velocidad: Las respuestas serían casi instantáneas, ya que la mayor parte del cálculo puede realizarse directamente en tu dispositivo.

- Flexibilidad: Es mucho más fácil actualizar o «reentrenar» un modelo pequeño (por ejemplo, para adaptarlo a la nueva interfaz de un sitio web de reservas) que tocar un LLM masivo.

- Seguridad y privacidad: Si los modelos funcionan en tu dispositivo, no es necesario enviar tus datos personales a servidores de terceros.

¿Qué impide la transición?

Si todo es tan bueno, ¿por qué no vivimos ya en un mundo de SLM? Los autores identifican tres barreras principales:

- Inercia de la inversión: Las empresas ya han invertido miles de millones de dólares en infraestructura para LLM y no tienen prisa por cambiar de rumbo.

- Fijación por los benchmarks: Los desarrolladores están acostumbrados a medir la «potencia» de los modelos en pruebas de conocimiento general, no en su eficiencia en tareas del mundo real.

- Bombo mediático: Toda la gloria y la atención de los medios se la llevan los modelos grandes, mientras que los SLM permanecen en la sombra.

Sin embargo, los autores confían en que la viabilidad económica y el sentido común acabarán prevaleciendo. Incluso proponen un algoritmo concreto sobre cómo los desarrolladores pueden hacer una transición gradual de sus agentes de LLM a SLM, recopilando datos sobre las solicitudes comunes y entrenando modelos especializados con ellos.